A Inteligência Artificial está cada vez mais presente em nosso dia a dia, de pesquisas no Chat-GPT a câmeras de celular que melhoram fotos automaticamente com IA.

Contudo, como toda tecnologia, a mesma capacidade que impulsiona a inovação pode ser instrumentalizada para fins maliciosos. Estamos entrando em uma nova era da cibersegurança, na qual os ataques virtuais não são mais apenas programados; eles aprendem, adaptam-se e evoluem.

Este artigo se propõe a dissecar como agentes mal-intencionados utilizam a Inteligência Artificial para orquestrar ataques mais sofisticados e evasivos. Para profissionais de dados e tecnologia, compreender esta nova fronteira não é apenas uma questão de curiosidade, mas uma necessidade para a construção de sistemas mais resilientes a ameaças virtuais.

O Paradoxo da IA na Segurança Digital

Como uma faca de dois gumes, a inteligência artificial serve tanto defensores quanto atacantes. Esta dualidade cria um cenário onde a corrida armamentista digital se intensifica exponencialmente. Mas o que torna os ataques baseados em IA tão distintos dos métodos tradicionais?

Pesquisadores da Universidade de Stanford demonstraram, ainda em 2018, que algoritmos de machine learning conseguem automatizar tarefas que anteriormente exigiam intervenção humana especializada. Consequentemente, atacantes agora executam campanhas de maior escala com recursos significativamente menores.

E se, em 2018, já era possível automatizar ataques, com a evolução das IAs Generativas os ataques virtuais têm potencial para se tornarem ainda mais personalizados e automatizados.

Principais Ataques Virtuais com Inteligência Artificial

1. Deepfakes e Manipulação de Mídia

Os deepfakes representam uma das aplicações mais visíveis da IA maliciosa. Estas tecnologias utilizam redes neurais generativas adversárias (GANs) para criar conteúdo audiovisual falsificado com qualidade quase indistinguível da realidade.

Um executivo recebe uma ligação do CEO solicitando transferência urgente de fundos. A voz soa familiar, convincente. Porém, algoritmos de clonagem vocal geraram essa solicitação fraudulenta. Este cenário foi documentado pelo FBI pela primeira vez em 2019 e ilustra como deepfakes de áudio facilitam fraudes empresariais.

De acordo com reportagem do Globo, em 2024, um criminoso utillizou Deepfake para criar uma reunião falsa com diretor financeiro de uma multinacional, que transferiu R$ 129 milhões sem perceber o golpe.

2. Ataques de Engenharia Social Automatizados

Tradicionalmente, campanhas de phishing dependiam de templates genéricos com baixas taxas de conversão. Entretanto, algoritmos de processamento de linguagem natural agora personalizam mensagens maliciosas em escala industrial.

Os modelos de IA Generativa possuem a capacidade impressionante de gerar texto persuasivo e contextualmente apropriado. Criminosos exploram essa tecnologia para criar emails de phishing altamente personalizados, consumindo APIs em tempo real.

Como resultado, as taxas de sucesso dessas ameaças aumentaram significativamente.

Imagine receber um email que menciona projetos específicos da sua empresa, colegas reais e detalhes precisos sobre sua função. Algoritmos de IA coletam essas informações de fontes públicas ou redes sociais, como o LinkedIn, e constroem narrativas convincentes. Esta personalização torna a detecção humana extremamente desafiadora.

3. Malware Inteligente e Evasão de Detecção

Sistemas de segurança tradicionais dependem de assinaturas conhecidas para identificar malware. No entanto, algoritmos de IA permitem que códigos maliciosos se adaptem dinamicamente para evitar detecção.

Ainda em 2017, pesquisadores da Universidade de Columbia desenvolveram malware que utilizava redes neurais para modificar seu comportamento baseado no ambiente de execução. Essencialmente, o malware”aprendia” como se camuflar em diferentes sistemas.

Além disso, técnicas de adversarial machine learning permitem que atacantes identifiquem pontos cegos em sistemas de detecção. Por exemplo, pequenas modificações em arquivos executáveis podem torná-los invisíveis para scanners baseados em IA.

4. Ataques de Negação de Serviço (DDoS) Inteligentes

Ataques de Negação de Serviço (DDoS) convencionais operam pela força bruta: inundam um servidor com tanto tráfego que ele não consegue mais responder a solicitações legítimas. As defesas, por sua vez, aprenderam a identificar e bloquear esses fluxos massivos e anormais de dados, através de plataformas como CloudFlare.

Um ataque de DDoS inteligente, no entanto, é mais sutil. Em vez de um tsunami de tráfego, ele gera um fluxo que mimetiza o comportamento de usuários reais. Um sistema de IA pode analisar o padrão de tráfego normal de um website e, em seguida, orquestrar uma botnet para gerar solicitações que pareçam legítimas.

Esses ataques, conhecidos como “low and slow”, podem visar pontos específicos e de alto custo computacional de uma aplicação, como uma busca complexa no banco de dados ou um endpoint de API que exige muito processamento. Como o tráfego parece normal, os sistemas de mitigação têm enorme dificuldade em distingui-lo do tráfego legítimo, exaurindo os recursos do servidor de forma silenciosa e eficiente.

Técnicas Avançadas de Ataque

Password Spraying Inteligente

Ataques de força bruta tradicionais testam combinações aleatórias de senhas. Contudo, algoritmos de machine learning analisam padrões humanos para gerar tentativas mais prováveis.

Pesquisadores da Stevens Institute of Technology criaram modelos que preveem senhas com precisão 43% superior aos métodos convencionais. Estes algoritmos consideram fatores como data de nascimento, nomes de familiares e preferências pessoais.

Consequentemente, organizações enfrentam ameaças mais sofisticadas mesmo com políticas de senha robustas. A personalização baseada em dados públicos torna esses ataques particularmente eficazes.

Reconnaissance Automatizado

A fase de reconhecimento determina o sucesso de ataques direcionados. Algoritmos de IA automatizam a coleta e análise de inteligência sobre alvos específicos.

Ferramentas como o Social Mapper utilizam reconhecimento facial para correlacionar perfis em diferentes redes sociais. Além disso, algoritmos de web scraping extraem informações corporativas de sites, documentos públicos e vazamentos de dados.

Esta automação permite que atacantes construam perfis detalhados de organizações e indivíduos em questão de horas, não semanas.

Ataques Adversariais contra Sistemas de IA

Paradoxalmente, sistemas de inteligência artificial também se tornam alvos de ataques específicos. Técnicas adversariais exploram vulnerabilidades inerentes aos modelos de machine learning.

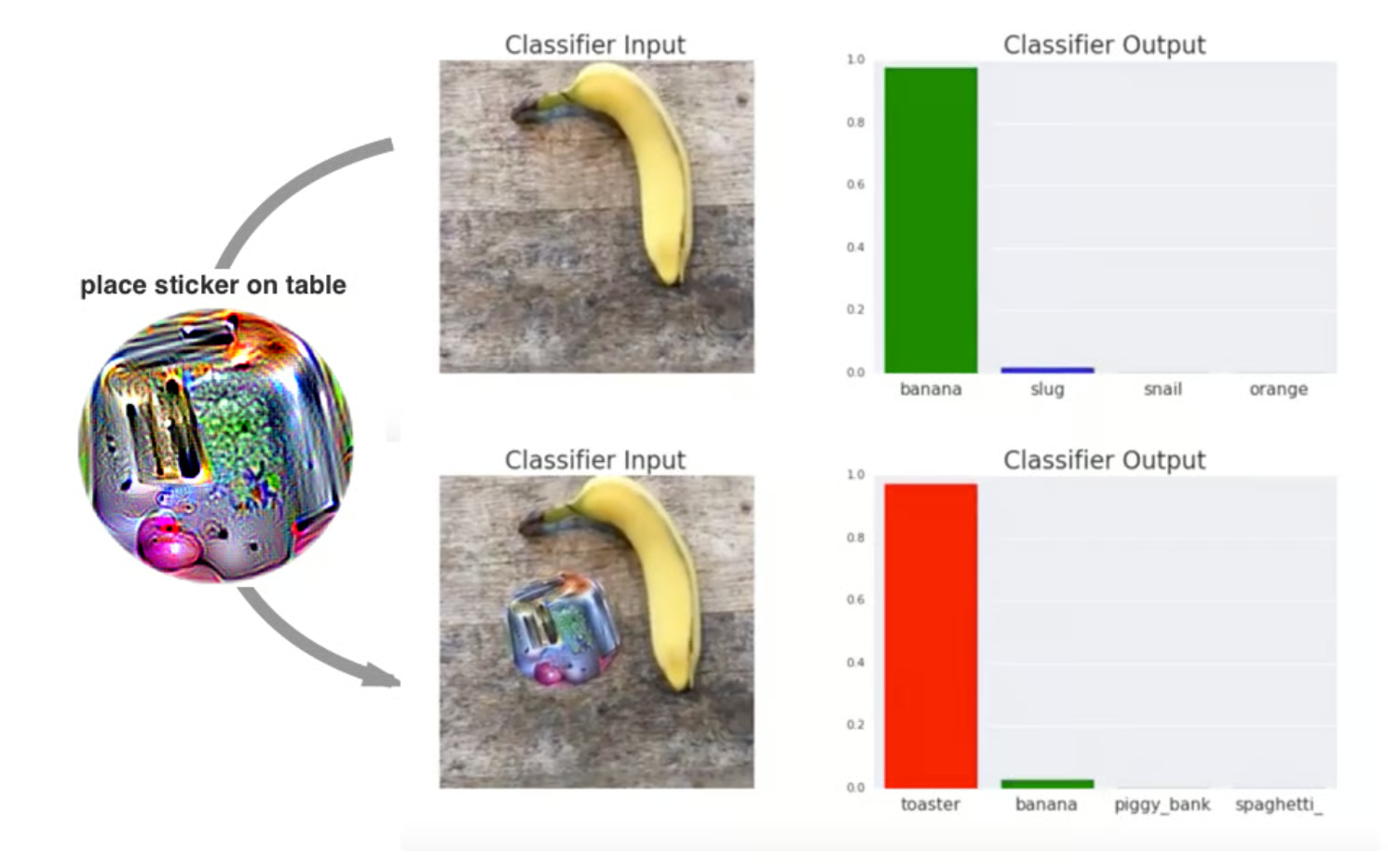

Por exemplo, pequenas perturbações em imagens podem enganar sistemas de reconhecimento visual embutidos em câmeras de vigilância. Pesquisadores demonstraram como adesivos estrategicamente posicionados fazem câmeras de segurança classificarem pessoas como objetos inanimados ou errar a classificação de um objeto. Eles podem ser impressos e adicionados a qualquer cena em tempo real para enganar um classificador de imagens

Similarmente, ataques de envenenamento de dados corrompem conjuntos de treinamento, causando comportamentos maliciosos em modelos de IA. Este tipo de sabotagem representa uma ameaça emergente para sistemas críticos.

Impactos e Consequências

Escalabilidade das Ameaças

A automização proporcionada pela IA permite que pequenos grupos de atacantes executem campanhas massivas. Um único indivíduo pode gerenciar milhares de ataques simultâneos usando algoritmos inteligentes.

Esta escalabilidade transforma o panorama de ameaças. Anteriormente, ataques sofisticados exigiam recursos substanciais e equipes especializadas. Agora, algoritmos democratizam capacidades avançadas de ataque.

Detecção Dificultada

Sistemas de segurança baseados em regras enfrentam dificuldades para identificar ataques adaptativos. Como estes ataques evoluem constantemente, assinaturas tradicionais se tornam ineficazes.

Ademais, a qualidade dos deepfakes e conteúdo gerado por IA continua melhorando. Uma pesquisa de 2025 da iProov demonstrou que menos de 1% da população consegue identificar com precisão diferentes estímulos de Deep Fake. Vale ressaltar que este percentual representa os indivíduos que acertaram todos os estímulos, não a taxa de acerto individual.

Erosão da Confiança Digital

Talvez o impacto mais significativo seja a erosão da confiança em comunicações digitais. Quando qualquer conteúdo pode ser falsificado convincentemente, como distinguimos informações autênticas?

Esta incerteza afeta não apenas indivíduos, mas também instituições democráticas, mercados financeiros e relações diplomáticas. O conceito de “verdade verificável” se torna mais complexo na era da IA.

Considerações Finais

Os ataques virtuais baseados em inteligência artificial representam uma evolução natural na guerra cibernética. Estas ameaças combinam sofisticação técnica com escalabilidade, criando desafios sem precedentes para profissionais de segurança.

Contudo, a mesma tecnologia que habilita esses ataques também oferece ferramentas poderosas de defesa. O sucesso na proteção contra ameaças de IA dependerá da capacidade das organizações de adaptar suas estratégias de segurança proativamente.

Em 2019-2020, atuei em um projeto de marketing para uma empresa brasileira de cybersecurity. Naquela época, já se dizia que a principal vulnerabilidade das empresas era o fator humano. Além de continuar sendo uma verdade, o fator humano é o principal alvo devido ao potencial de personalização de ataques com inteligência artificial.